什么是强化学习

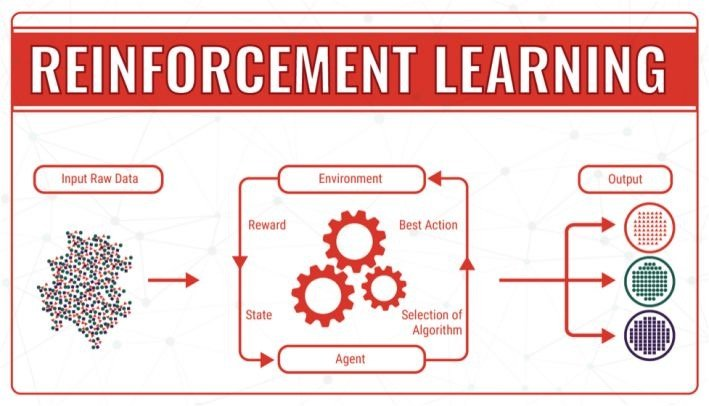

根据维基百科的定义:强化学习(Reinforcement Learning,简称RL)是机器学习中的一个领域,强调如何基于环境而行动,以取得最大化的预期利益.

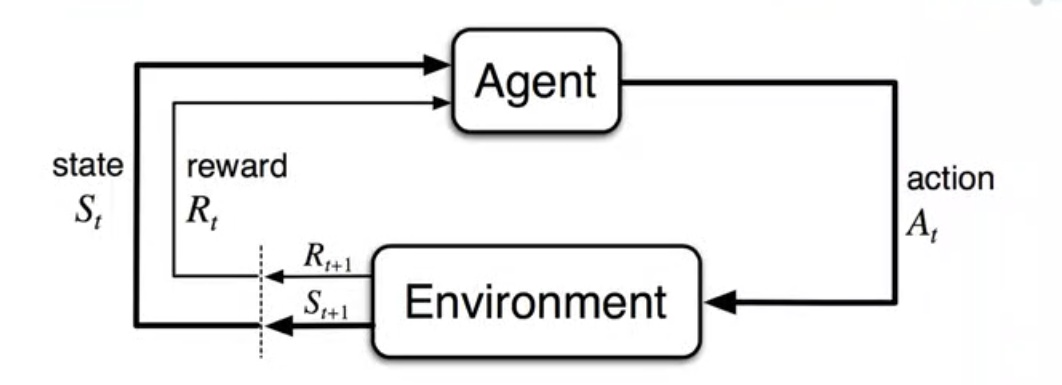

强化学习包括4个要素:

- 策略(policy):环境的感知状态到行动的映射方式

- 反馈(Reward):环境对智能体行动的反馈

- 价值函数(Value-function):评估状态的价值函数,状态的价值即从当前状态开始,期望在未来获得的奖赏

- 环境模型(model):模拟环境的行为

RL的分类

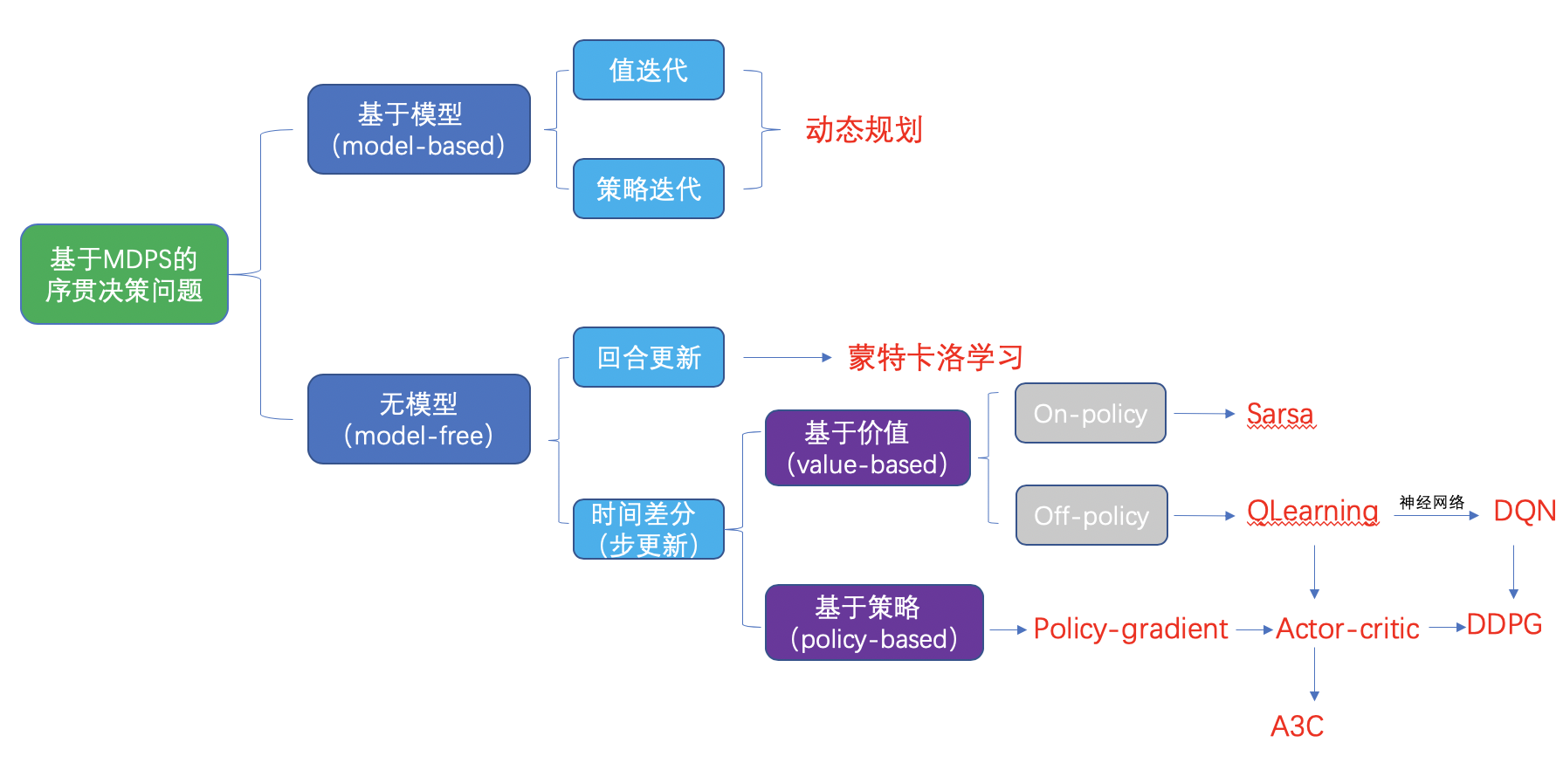

强化学习的分类汇总: - 第一种分类方式

- model-free:QLearning、Sarsa、Policy Gradients

- model-based:需要对环境增加建模的步骤

- 第二种分类方式

- 基于概率(policy-based):Policy-gradients

- 基于价值(value-based):QLearing、Sarsa

- Actor-Critic:结合了上面的两种方式,Actor基于概率做出动作,Critic会对做出的动作给出价值

- 第三种分类方式

- 回合更新(Monto-Carlo update):Monto-Carlo Learning

- 单步更新(Temporal-difference update):QLearning、Sarsa

- 第四种分类方式

- 在线学习(on-policy):Sarsa、Sarsa(λ)

- 离线学习(off-policy):QLearning、DQN

RL的特点

强化学习的特点:

- 起源于动物学习心理学的试错法(trial-and-error),因此符合行为心理学

- 寻求探索(exploration)和采用(exploitation)之间的权衡:强化学习一面要采用(exploitation)已经发现的有效行动,另一方面也要探索(exploration)那些没有被认可的行动,已找到更好的解决方案

- 考虑整个问题而不是子问题

- 通用AI解决方案

强化学习是机器学习的重要部分,在为机器学习开拓新方向上做出了巨大的贡献。强化学习突破了非监督学习,为机器和软件如何获取最优化的结果给出了一种全新的思路。它将如何最优化主体的表现和如何优化这一能力之间建立起了强有力的链接。通过奖励函数的反馈来帮助机器改进自身的行为和算法。